ChatGPT大爆发,离不开这些AI芯片!

什么是Chatgpt,就是一款聊天机器人

不过聊天机器人不是个新鲜的概念,只是这两年随着数据和算力的提升,机器人的深度学习模型也在提升,真正看到在商业应用端的可行性,本文就从底层技术和算力芯片说起,简简单单让你看明白是怎么回事!

开始之前,我们先从CHATGPT的3个底层技术说起:

1.自然语言处理模型(npl)

以前聊天机器人在语音识别上的技术是可以的,比如小度和小米等设备都可以完成基础的语音识别工作。但是在处理自然语言是,机器人显然像个弱智,因为自然语言抽象,又有组合多数时候还要配合着背景去猜测,想象下咱们人与人之间的交流难度,场景之复杂;要想机器人真的达到聊天的水平,必须要建立足够大的语言学习模型,包含足够多的语言数据库来训练机器人才行。这就是要被突破的自然语言处理技术。

2.计算机视觉(cv)

说完语言还要说视觉,让机器人更智能,交互性更强,必须要学会图像识别;同样的技术逻辑,图像识别的学习需要海量的图像数据库(这也是为啥sj中国冲起的原因)。这个技术现在仍然在初步,进度远远落后于语言处理技术;因为图片的模型更加复杂。

3.多模态学习

什么叫多模态学习模型?就是机器通过学习学会处理不同信息来源的能力,不同信息包括文本,图像,视频,音频等等;最终能达到一个综合处理融合的能力,那可不就是一个简单的人脑嘛。

关于底层技术,国外的谷歌和微软走在最前沿,领先我们3年不止,国内的百度和华为等也在奋力追赶。但是整个行业的技术都在进步革新中,远未成熟。

只要谈到AI那就离不开大量数据和学习;所以对chatgpt来说,最核心的是算力,算力能否支持对如此海量数据的提取,清洗和学习成为AI发展关键,算力就像引擎发动机,算力的关键就是芯片。

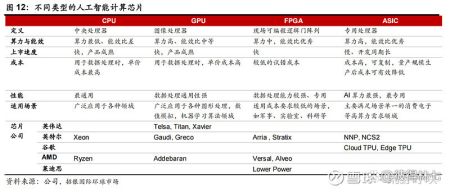

AI芯片为人工智能提供基础算力,分为GPU,FPGA和ASIC,随着 AI 技术快速发展,AI 应用场景会扩大到智能制造、家居、教育、医疗和金融等行业;而智能产品种类的持续升级也对芯片算力提出更高要求,AI 芯片算力和需求将会大大增加,据 Frost&Sullivan 预计,2022-2026年全球 AI 芯片市场规模将以26.3%复合增速增长。

AI 芯片

AI芯片能为人工智能应用提供所需的基础算力;按技术架构主要分为GPU、FPGA和ASIC。ChatGPT 有着大量复杂计算需求的 AI 模型,AI 芯片主要分为三种,分别是 GPU, FPGA 与 ASIC 芯片。不同种类别的 AI 计算芯片有各自突出的优势和适用的领域,贯穿 AI 训练与推理阶段。

1. GPU

GPU,图形处理器,目前GPU 是 AI 应用的主导芯片,因为它具有强大的计算能力和高通用适用性,而且开发成本较低,使用比较广。

ChatGPT 作为有着大量复杂计算需求的 AI 模型,GPU 芯片成为能帮助其完成计算任务的关键硬件之一;随着深度学习技术发展,GPU 成为 AI 算法训练中重要硬件组成部分。同时,随着云计算技术发展,云端对 GPU 算力要求在不断提升。

市场空间:

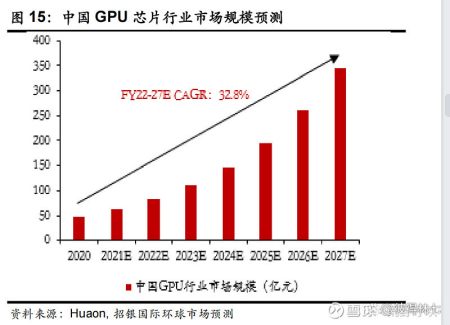

据机构预测:2022-2026年全球 GPU 出货量复合增速为6.3%,预计2027年行业市场规模将超320亿美元。

相关公司(不做推荐只分享产业链公司):

全球:英伟达,英特尔和AMD

国内是GPU龙头是景嘉微,不过海光和寒武纪也在布局GPU.

2. FPGA(现场可编程门阵列)

FPGA :是一种硬件可重构的集成电路芯片,通过在硅片上预先设计实现具有可编程特性,可通过软件重新配置芯片内部的资源来实现不同功能,简单说就是软硬通吃,双重优势。比如特斯拉的FSD就是一款FPGA 芯片,通过远程更新来实现功能的升级换代。

所以它比ASIC、GPU 更灵活,在5G 通信、人工智能等迭代升级周期频繁、技术不确定性较大的领域,FPGA 是比较理想的解决方案。

市场空间:

随着全球通信设备的升级和人工智能与自动驾驶技术等新兴市场领域需求的不断增长,预计全球 FPGA 在2021-2025的市场规模年均复合增长率约为10.8%,2025年将达到125.2亿美元,中国 FPGA 市场规模快速增长,预计2021-2025年规模复合增速17.1%。

相关公司:全球 FPGA 市场主要被赛灵思和 Altera 占据,市占率分别为52%和35%;中国 FPGA 厂商中紫光国微、复旦微电和安路科技在2021年市占率超过15%。国产替代逻辑加强,国内市场空间也很大。

3. ASIC :

也是一种专用集成电路,优点是高性能、低能耗的特点,专用化程度最高,虚拟币领域用的比较多,比 GPU、FPGA能效更高。但目前 ASIC渗透率依然较低,因为他的研发成本和壁垒都很高,所以市场份额显著小于 GPU。ASIC 芯片依赖于它的卓越性能及低功耗,将成为人工智能技术的首选。

市场空间:预计到2027年,全球 ASIC 市场规模预计将达1677.49亿元,2021-2027年均复合增长率为8.9%。

相关公司(不做推荐只分享产业链公司)

全球:英伟达,谷歌,英特尔

国内:百度和寒武纪

别忘了计算芯片还需要内存作支撑!

内存芯片DRAM:高性能计算芯片需要搭配的 DRAM 内存数量大幅增加,DRAM 特征是读写速度快、延迟低,常用于计算系统的运行内存。

市场空间:相对以上三种芯片,DRAM具有强周期性,目前需求比较疲软,像三星等积压库存也比较多。

相关公司:

全球:三星、美光、SK 海力士

国内:兆易创新

AI芯片领域,全球大哥的排名还是比较清晰的,但是芯片国产替代的逻辑下,这一波技术革新里,国内谁能走出来?

- 00:00-00:13:演讲者介绍了视频的主题,即对ChatGPT的人工智能硬件进行深入探讨。他们首先强调了ChatGPT令人印象深刻的能力,它是目前使用的最先进的人工智能模型之一。演讲者指出,ChatGPT是一个自然语言处理模型,能够对文本提示产生类似人类的反应。

- 00:13-00:14:发言人指出,ChatGPT是在微软的一台超级计算机上训练的,但所涉及的硬件的确切细节并不清楚。他们解释说,ChatGPT的训练过程可能涉及使用大量的CPU和GPU资源来处理和分析大量的文本数据。

- 00:14-00:16:发言人指出,虽然不知道用于训练ChatGPT的CPU核心的确切数量和CPU类型,但显然微软利用了大量的计算能力来训练该模型。他们解释说,训练过程的目标是使ChatGPT能够对各种各样的文本提示产生类似人类的反应,这需要大量的计算资源。

- 00:16-00:19:发言人指出,虽然ChatGPT是在微软的超级计算机上训练的,但它使用微软的Azure服务器进行推理。他们解释说,推理是使用训练好的模型来生成对文本提示的回应的过程,这个过程也需要大量的计算能力。演讲者指出,微软Azure服务器是为处理大规模人工智能工作负载而设计的,它们非常适合为ChatGPT运行推理的任务。

- 00:19-00:20:演讲者在视频的最后总结了介绍中涉及的关键点。他们指出,ChatGPT是目前使用的最先进的人工智能模型之一,它是在微软的超级计算机上使用大量的计算能力进行训练的。他们解释说,虽然所涉及的硬件的确切细节不为人知,但很明显,微软利用了大量的CPU和GPU资源来训练这个模型。最后,他们指出,虽然ChatGPT使用微软的Azure服务器进行推理,但在未来,对文本提示产生类似人类反应的过程可能会继续需要大量的计算能力。

深挖ChatGPT的硬件

大家好!在下面这个视频里,我们深入探讨了ChatGPT的人工智能硬件,提供了有价值的洞见,介绍了用于训练和运行ChatGPT推断的硬件。首先,我们聊了聊参与此过

ChatGPT,人类认知力延伸的竞赛

2022年11月30日,OpenAI发布了ChatGPT,在全球范围内引发了人工智能热潮。ChatGPT(ChatGenerativePre-trained