深挖ChatGPT的硬件

大家好!在下面这个视频里,我们深入探讨了ChatGPT的人工智能硬件,提供了有价值的洞见,介绍了用于训练和运行ChatGPT推断的硬件。首先,我们聊了聊参与此过程的CPU和GPU,发现ChatGPT很可能是在类似Megatron Touring NLG的系统上进行训练的,该系统使用了120个AMD Epic GPU和超过70,000个CPU核心,以及4480个Nvidia A100 GPU。

- 00:00-00:13:演讲者介绍了视频的主题,即对ChatGPT的人工智能硬件进行深入探讨。他们首先强调了ChatGPT令人印象深刻的能力,它是目前使用的最先进的人工智能模型之一。演讲者指出,ChatGPT是一个自然语言处理模型,能够对文本提示产生类似人类的反应。

- 00:13-00:14:发言人指出,ChatGPT是在微软的一台超级计算机上训练的,但所涉及的硬件的确切细节并不清楚。他们解释说,ChatGPT的训练过程可能涉及使用大量的CPU和GPU资源来处理和分析大量的文本数据。

- 00:14-00:16:发言人指出,虽然不知道用于训练ChatGPT的CPU核心的确切数量和CPU类型,但显然微软利用了大量的计算能力来训练该模型。他们解释说,训练过程的目标是使ChatGPT能够对各种各样的文本提示产生类似人类的反应,这需要大量的计算资源。

- 00:16-00:19:发言人指出,虽然ChatGPT是在微软的超级计算机上训练的,但它使用微软的Azure服务器进行推理。他们解释说,推理是使用训练好的模型来生成对文本提示的回应的过程,这个过程也需要大量的计算能力。演讲者指出,微软Azure服务器是为处理大规模人工智能工作负载而设计的,它们非常适合为ChatGPT运行推理的任务。

- 00:19-00:20:演讲者在视频的最后总结了介绍中涉及的关键点。他们指出,ChatGPT是目前使用的最先进的人工智能模型之一,它是在微软的超级计算机上使用大量的计算能力进行训练的。他们解释说,虽然所涉及的硬件的确切细节不为人知,但很明显,微软利用了大量的CPU和GPU资源来训练这个模型。最后,他们指出,虽然ChatGPT使用微软的Azure服务器进行推理,但在未来,对文本提示产生类似人类反应的过程可能会继续需要大量的计算能力。

运行ChatGPT可不是省油的灯,估计每天要花费50万至100万美元呢!需要超过3500个Nvidia A100服务器和近30,000个A100 GPU。这么大的硬件数量,证明了该模型的复杂性和精密性,以及为其提供动力所需的资源。

即将彻底改变人工智能硬件市场的新硬件发展,例如Nvidia的Hopper代和基于CDNA3的MI 300 GPU,这些硬件发展是专门为人工智能工作负载设计的,可以帮助降低大规模运行推断的成本。

未来的人工智能将依赖于专门为人工智能工作负载设计的专用人工智能引擎和处理单元。几年后,训练像ChatGPT这样的模型将成为大学机器学习课程的一部分,而运行推断将在智能手机内部的专用人工智能引擎上完成。这些人工智能硬件的进步将为研究人员和开发人员提供必要的工具,以创建更复杂和有用的人工智能模型,并有助于推动人工智能研究和发展领域的进步。

ChatGPT训练一次相当于120个美国家庭一年耗电

当你走进OpenAI的实验室,你会看到一排排高大的机柜,里面装满了闪耀着绿色光芒的芯片。这些是OpenAI购买的英伟达顶级AI芯片,价值几十亿人民币,其消耗的电力更是天文数字。这些芯片的数量之多,让人不禁感叹,ChatGPT背后需要的硬件条件之强大。

那么,这些昂贵的硬件和电力为什么如此重要呢?美国人在一个聊天机器人上投入如此巨大,又是为什么呢?

为了让ChatGPT可以发挥出最佳的性能,OpenAI购买了超过3万颗英伟达顶级AI芯片,每一颗芯片的价格都将近10万元人民币,仅这些芯片就相当于30亿人民币。这还不包括其他硬件设备和配件的费用!

为什么需要购买这么多芯片?这是因为ChatGPT需要大量的计算资源才能运行。每一次对话都需要进行大量的计算,包括自然语言处理、语义理解、逻辑推理等等,这些都需要海量的计算资源来完成。

而这些计算资源,就需要靠这些昂贵的芯片来支持。就好比小轿车和赛车,小轿车只需要一台普通的发动机就能跑起来,而赛车则需要高性能的引擎和配件才能达到极限速度。

但仅仅购买这些昂贵的芯片,还不足以支撑ChatGPT的运行。每个月,ChatGPT维持运转所需要的电费就相当于1000多万元人民币!这个数字让人瞠目结舌。要知道,这个数字相当于一家中型企业一个月的总收入。

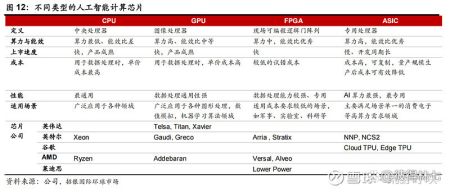

1. GPU

GPU,图形处理器,目前GPU 是 AI 应用的主导芯片,因为它具有强大的计算能力和高通用适用性,而且开发成本较低,使用比较广。

ChatGPT 作为有着大量复杂计算需求的 AI 模型,GPU 芯片成为能帮助其完成计算任务的关键硬件之一;随着深度学习技术发展,GPU 成为 AI 算法训练中重要硬件组成部分。同时,随着云计算技术发展,云端对 GPU 算力要求在不断提升。

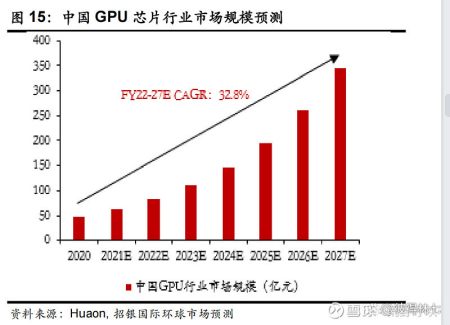

市场空间:

据机构预测:2022-2026年全球 GPU 出货量复合增速为6.3%,预计2027年行业市场规模将超320亿美元。

相关公司(不做推荐只分享产业链公司):

全球:英伟达,英特尔和AMD

国内是GPU龙头是景嘉微,不过海光和寒武纪也在布局GPU.

2. FPGA(现场可编程门阵列)

FPGA :是一种硬件可重构的集成电路芯片,通过在硅片上预先设计实现具有可编程特性,可通过软件重新配置芯片内部的资源来实现不同功能,简单说就是软硬通吃,双重优势。比如特斯拉的FSD就是一款FPGA 芯片,通过远程更新来实现功能的升级换代。

所以它比ASIC、GPU 更灵活,在5G 通信、人工智能等迭代升级周期频繁、技术不确定性较大的领域,FPGA 是比较理想的解决方案。

ChatGPT大爆发,离不开这些AI芯片!

什么是Chatgpt,就是一款聊天机器人