ChatGPT启示录!OpenAI街尾这家博物馆,展示人类毁灭未来

【新智元导读】随着ChatGPT的大热,人们对AGI的讨论也日渐激烈。开在旧金山的错位博物馆,构想了AGI将大部分人类摧毁的未来世界。

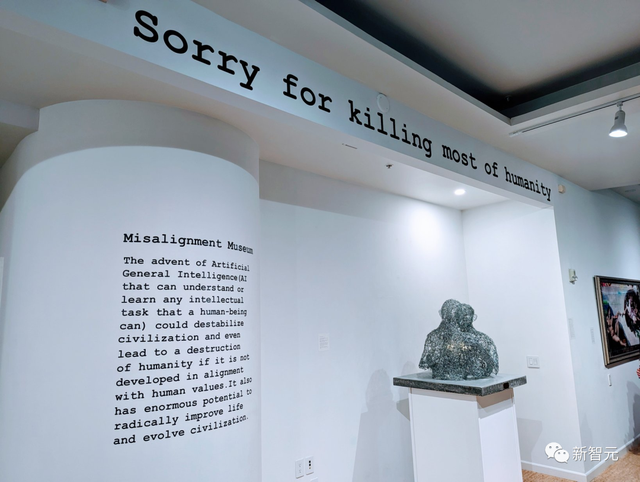

「Sorry for killing most of humanity!」

3月3日,位于旧金山的错位博物馆(Misalignment Museum)正式开幕。

这是一家艺术博物馆,里面陈列出关于通用人工智能(AGI)对人类未来影响的展品。

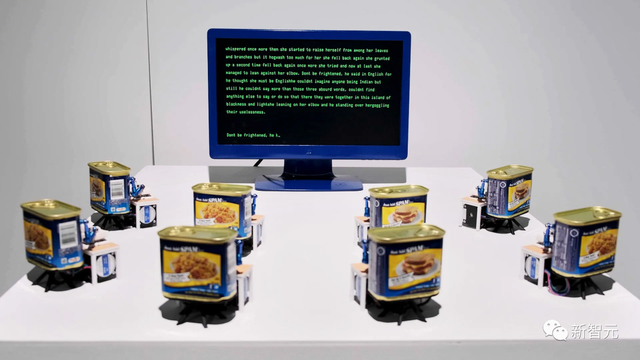

最让人瞩目的作品是「回形针拥抱」,在其上方还贴上了「抱歉杀死了大部分人类」标语。

有趣的是,这家博物馆距离OpenAI办公室只有8个街区。

OpenAI办公楼

ChatGPT的横空出世,让人们对人工智能的疯狂又回到了2016年AlphaGo完胜李世石那一天。

随之而来的,对AGI的探讨愈演愈烈。

甚至,上周OpenAI首席执行官,ChatGPT之父Sam Altman发文,分享了OpenAI对通用人工智能的当前和后续规划。

这家错位博物馆,或许是很好的AI启示录。

是时间错位?

Audrey Kim是这家错位博物馆的馆长。

接受wired采访时,她谈到,Audrey Kim的狗用点头和地上的10个按钮来和她交流。

Kim教它使用这些按钮是因为她相信意识是一个光谱,智力是神秘的,她还认为自己的狗喜欢和乌鸦交朋友。

这些信条也促使她策划了这一场关于AI未来的展览。

错位博物馆展现了这样一个未来:AI就像无数科幻电影中描绘的那样,具有了自我意识并且开始残杀人类。幸好,在Kim的设想中,算法会自动纠正,并且最终停止杀戮。

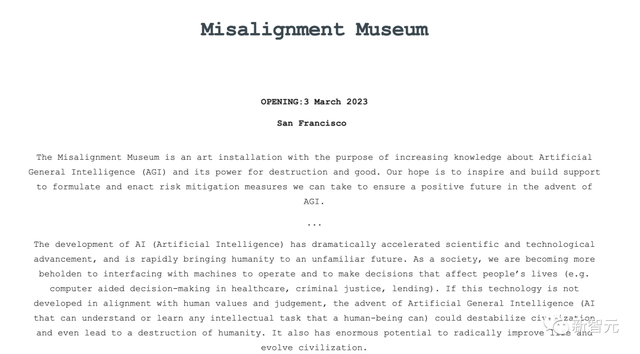

根据错位博物馆介绍,

错位博物馆是一家艺术博物馆。开设这家博物馆是为了增加人们对通用人工智能,及其破坏力和善的力量的了解。我们希望激励和建立支持,以制定和颁布我们可以采取减少风险的措施,确保在AGI来临之际有一个积极的未来。

人工智能的发展极大地加速了科学和技术的进步,并迅速将人类带入一个陌生的未来。作为一个社会,我们正变得更加依赖与机器的互动,来操作和做出影响人们生活的决定(比如,在医疗保健、刑事司法、借贷等方面由计算机辅助决策)。

如果这项技术不能与人类的价值观和判断相一致,那么AGI的出现就可能破坏文明,甚至导致人类的毁灭。不可否认,它也有巨大的潜力,可以从根本上改善生活,促进文明发展。

Misalignment Museum官网

展览在5个月前便开始筹划了,也就是ChatGPT引发科技新一轮热潮的不久之前。

对于AGI的概念目前尚未达成共识,而博物馆给出的定义,能理解或学习任何人类能够完成的智力任务的人工智能。

Kim表示,展览的目的在于引起人们对AI技术带来的不确定影响的讨论。

博物馆分为两层。楼上是对AI的乐观展望,有用细菌创作的钢琴音乐、和米开朗基罗在西斯廷教堂创作的「创造亚当」的互动剧,以及一个使用谷歌的计算机视觉来描述出现在镜头前的人或物的装置。

楼下则是反乌托邦式的场景。

有黑客帝国场景的复现,(电影的布景设计师Barbara Munch Cameron协助策展),展示了一个拿着笔的机械臂站在AI的角度上不断写下将人类视为威胁的笔记的场景。

博物馆下层入口上方悬挂着但丁的话:「入此门者,放弃一切希望吧!」

博物馆里还有Arnold Schwarzenegger根据ChatGPT生成的脚本进行的深层模仿,一个由15000个回形针制成的两个人拥抱的雕像,寓意人工智能安全。

还有从维也纳空运来由垃圾罐头制成可以打字的手臂机器人。

「Spambots」创造了一个人工智能生成的美丽新世界——Neil Mendoza

Kim是谷歌的早期员工,也曾在联合国工作,并担任过Y Combinator联合创始人Paul Graham的助理。

她认为,「AI技术可以带来很多好处,防止很多痛苦,但它也可以造成很多破坏。研究人员对AI的未来也没有确定的答案,目前所能做得只是提供给人们足够的角度与方式,来认真思考这项技术。」

另外,这个博物馆也展现了一些科技创始人和思想家的影响,比如Facebook联合创始人Dustin Moskovitz关于AI和有效利他主义的推文框。

再比如展览入口附近装满意面的浴缸,这来自于资助了OpenAI的一家慈善组织的联合创始人Holden Karnofsky的想法。

他认为,人类正生活在一个十分重要的历史时期,即将面临AI带来的变革,他将这一时期称之为自动化科技进步历程(Process for Automating Scientific and Technological Advancement,PASTA)。

除了展示有关AI的艺术创作,错位博物馆还计划放映电影,比如《终结者》、《机械姬》、《她》,探讨AI技术造成负面影响的可能。

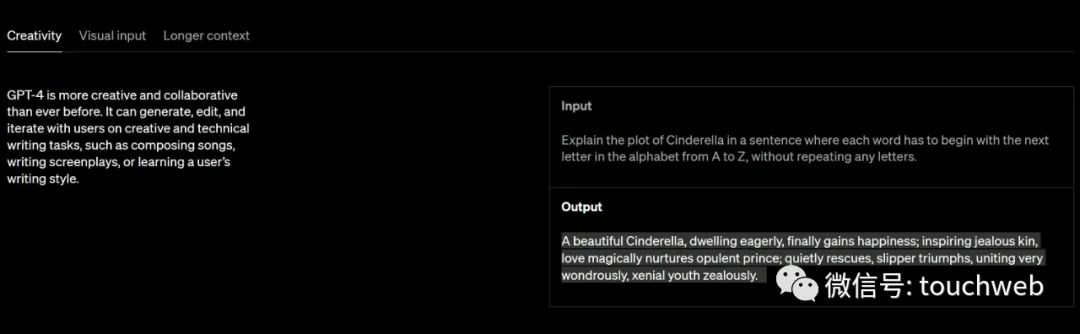

ChatGPT式启发

最近关于AI未来的预测,主要集中在ChatGPT及其相关技术上。

而「回形针环抱」这一展品暗含了「回形针最大化机器」(Paperclip Maximizer)思想实验。

牛津大学哲学家Nick Bostrom在他200年的《超级智能》一书中曾介绍了这一思想实验:

如果一个强大的AI,它的设计初衷只是求得计算的最优解,它会因为缺少人类的价值观,而失去对社会、对环境、对全局的思考。

这也是为什么在ChatGPT面世后,网友称,「Clippy is coming」。

押注生成式AI的企业家们提出了狂热的主张。上周,OpenAI的CEO还发表了一篇关于该公司如何 「规划AGI 」的博文。

此后不久,防止欺骗性商业行为的美国联邦贸易委员会,警告营销人员不要对其技术所能完成的任务进行虚假宣传。委员会律师Michael Atleson发文称,「科幻小说里计算机通常能对人类行为做出值得信赖的预测,但我们并不是生活在小说里。」

许多AI研究人员认为,虽然ChatGPT等生成式AI的能力使人感到惊艳,但这种技术不该被认为是智能的,因为其算法只是对训练数据进行重复和混合加工。

在这种观点下,最好把今天的狭义人工智能看成一个类似计算器,或烤面包机的工具,而不是一个有思想的生命体。

一些AI伦理学家认为,将感知等人类特征赋予机器,会淡化人们对其他形式的有害自动化的关注,比如监控技术。

Kim最早熟悉机器学习是在作为Cruise的员工的时候,从那时她开始思考,虽然正常工作的AI能够消除很多不必要的死亡和痛苦,但当其不工作或不正常工作时,也给人类生命带来了巨大风险。

Kim认为AI终将影响到所有人,而她希望做到的,是让尽可能多的人意识到这一点并形成自己的思考。

这场临时展览由一位匿名捐赠者资助举办到5月,并在周四、周五、周六对公众开放,还计划面向学校团体举办参观活动。

TIME曾发文「不可控的人工智能比以往任何时候都更有可能出现」。

近期生成式AI领域的突飞猛进,让这样一个问题摆上桌面:如果打造AGI的尝试真的成功了,会出现怎样的局面呢?

真正的AGI不仅可以改变世界,还可以改变自己,这可能会引发一个正反馈循环,越来越好的AI会创造出越来越好的AI,突破已知的理论限制。

根据最近的有关AI造成的影响的调查,731名优秀的AI研究人员中,有近一半认为人类水平的AI至少有10%的可能性会导致极其负面的结果。

已经有很多研究人员涉足于AI安全领域,致力于控制未来更强大的AI使其与人类的价值观保持一致。但即便能从技术上实现一致,但这个作为标准的价值观,能得到普罗大众的认同吗?还是仅仅代表了少数精英的观点?

目前能做的,就是让尽可能多的公众了解AGI的风险,毕竟这一技术的实现可能就在不远的未来。