ChatGPT在超过一半的软件工程问题上回答错误

ChatGPT作为一个能够随时提供对话式回答的聊天机器人,对于您的信息需求来说是一个方便的资源。

尽管很方便,但一项新的研究发现,您可能不希望在软件工程提示方面使用ChatGPT。

在AI聊天机器人出现之前,Stack Overflow是程序员们寻求项目建议的首选资源,其问答模式与ChatGPT类似。

然而,在Stack Overflow上,您必须等待有人回答您的问题,而使用ChatGPT则不需要。

因此,许多软件工程师和程序员已经转向ChatGPT寻求帮助。由于没有数据显示ChatGPT在回答这些类型的提示时的效果如何,一项新的研究调查了这个困境。

为了弄清楚ChatGPT在回答软件工程提示时的效率如何,研究人员给ChatGPT提供了517个Stack Overflow问题,并检查了这些答案的准确性和质量。

结果显示,在512个问题中,ChatGPT的答案中有259个(52%)是错误的,只有248个(48%)是正确的。此外,惊人的是,77%的答案冗长而啰嗦。

尽管答案的准确性显著不高,但结果显示,这些答案在65%的时间里是全面的,并涵盖了问题的所有方面。

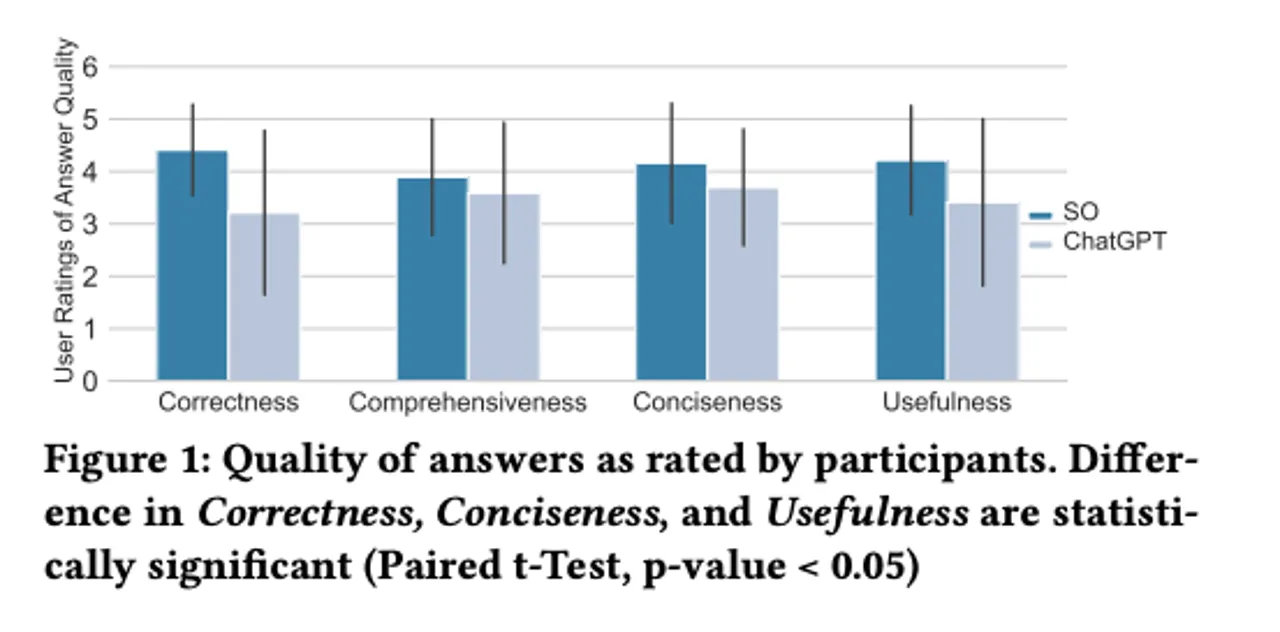

为了进一步分析ChatGPT回答的质量,研究人员请12位具有不同编程专业水平的参与者提供他们对答案的见解。

尽管参与者们在各个类别上更喜欢Stack Overflow的回答,但他们在39.34%的时间里无法正确识别ChatGPT生成的错误答案。

根据这项研究,ChatGPT输出的表达清晰的回答导致用户忽视了答案中的错误信息。

作者写道:“由于ChatGPT答案中的全面、清晰和人性化见解,用户在ChatGPT答案中忽视了错误信息(39.34%的时间)。”

虽然这种生成听起来合理但错误的答案是所有聊天机器人中的一个重要问题,因为它会导致错误信息的传播。

除了这个风险,低准确性得分应该足以让您重新考虑使用ChatGPT来回答这些类型的提示。