欲与英伟达决高下?英特尔推云端AI芯片拟联手国内厂商开发AI服务器

《科创板日报》7月12日讯(黄心怡)7月11日,英特尔在中国市场推出云端AI训练芯片——Habana[gf]ae[/gf] Gaudi[gf]ae[/gf]2。该芯片可满足大规模语言模型、多模态模型及生成式AI模型的需求。据现场介绍,该芯片性能在一些关键指标上胜过英伟达A100。

据了解,该Gaudi2处理器及Gaudi2夹层卡HL-225B,以第一代Gaudi高性能架构为基础,具有24个可编程Tensor处理器核心(TPCs)。

每颗芯片集成了21个专用于内部互联的100Gbps(RoCEv2 RDMA)以太网接口,配备配置96GB HBM高速内存及2.4TB/秒的总内存带宽,满足大规模语言模型、多模态模型及生成式AI模型的需求。

据现场介绍,英特尔Gaudi2运行ResNet-50的每瓦性能约是英伟达A100的2倍,运行1760亿参数BLOOMZ模型的每瓦性能约达A100的1.6倍。

在发布会上,浪潮信息高级副总裁、AI和HPC总经理刘军现场发布搭载Gaudi2的新一代AI服务器NF5698G7。

目前,英特尔已与浪潮信息合作,打造基于Gaudi2深度学习加速器的AI服务器NF5698G7。该服务器集成了8颗Gaudi2加速卡HL-225B,还包含双路第四代英特尔至强可扩展处理器,支持AMX/DSA等AI加速引擎。当日,该款AI服务器也正式发布。

浪潮信息高级产品经理王磊强调,NF5698G7是专为面向生成式AI市场开发的新一代AI服务器,支持8颗OAM高速互联的Gaudi2加速器,将为AI客户提供大模型训练和推理能力。

新华三集团计算存储产品线副总裁刘宏程表示,基于英特尔Gaudi2 AI加速器,新华三正与英特尔合作,开发适合大模型训练和推理的高性能AI服务器。

同时,超聚变数字技术有限公司算力基础设施领域总裁唐启明指出,超聚变将与英特尔,共同推出基于Gaudi2的全新产品与解决方案。

此前,英特尔中国区董事长王锐在接受《科创板日报》采访时指出,ChatGPT浪潮带来计算需求的大幅度提升,目前正与包括百度、阿里等在内的中国的客户开展共同研究。王锐透露,不管是高性能的计算还是分布式的计算,都已经进行了布局。

一位英特尔技术专家《科创板日报》分享了英特尔在大模型领域的布局情况。在训练层面,针对CPU、GPU、IPU、Habana等异构计算,英特尔用oneAPI以及XPU平台来提供更多的选择。在推理方面,第四代Sapphire Rapids发布后,基于AMX加速器,可在行业中解决80%以上的客户推理需求。同时,也充分利用CPU,包括用于训练的Ponte Vecchio,和用于推理的Arctic Sound等。

伴随着大模型的热潮,云计算的商业模式正朝着MaaS(模型即服务)的方向演进,其所带来的算力需求也值得关注。

它的理念是利用预训练模型,对行业数据进行训练,从而形成针对特定场景的、面向各行业的细分模型。我们知道通用模型的参数量非常大,例如GPT-3可达到1750亿,部署这些模型会比较麻烦,因此,可能需要对大模型进行蒸馏和压缩,形成行业可部署的模型。上述技术专家称。

此外,把大模型进行私有化部署是不少行业的潜在需求。很多细分行业不接受SaaS服务,尤其金融等行业。因此,英特尔正在探讨如何把这个模型小型化之后,在本土落地做私有化部署,使其真正在行业落地。

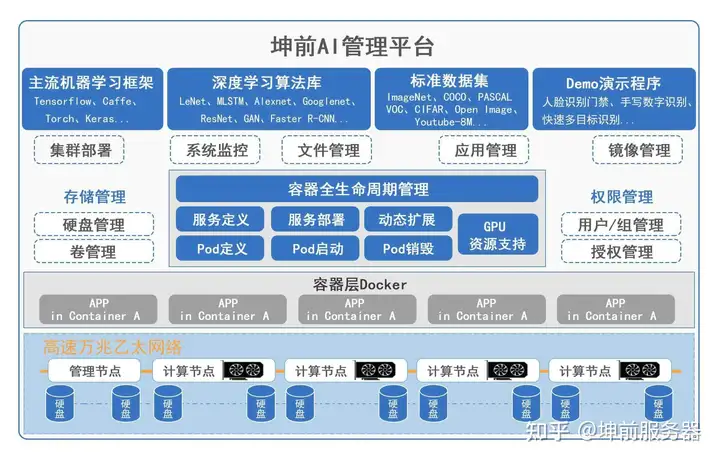

实际案例表明,在没有基站的情况下,AI服务器的GPU总体利用率通常仅为40%。经过人工智能的统一管理后,GPU的利用率提高乐将近一倍,可以达到70%以上,整体资源效率得到巨大提升。

其次,可以减少等待时间并提高模型培训效率。对于多任务处理,AI服务器支持细粒度视频内存分配,最小作用力可以精确到1g。使用GPU共享策略,多人可以共享一张GPU卡,而不会相互影响。

参考链接: