OpenAI为节约成本偷工减料?史上最强大模型GPT-4“变笨”

如今距离OpenAI于3月中旬推出其最新版本的大型语言模型GPT-4已经有近3个月的时间。这段时间内,尽管全球资本市场对人工智能、大模型和算力的炒作此起彼伏,也有人称赞GPT-4这个版本强大的能力,但却很少有人质疑GPT-4是否真的比此前更早期的版本强大。

近期,网上对GPT-4是否出现退化的质疑声开始涌现出来,越来越多的网友开始表示,GPT-4对复杂程度相似的问题处理结果甚至还不如它的前身GPT-3或GPT-3.5。面对网友的大量质疑,OpenAI官方开发者推广大使回应称,GPT-4处于静止状态,且自3月 14日发布以来没有做过改动。

可能突破万亿参数的GPT-4,被OpenAI“狂吹”

根据OpenAI自己的说法,GPT-3拥有1750亿个参数,但GPT-4的规模可能会达到数千亿个参数,甚至可能会突破万亿级别。这一规模的提升将有助于提高模型的表现力和泛化能力,使其更能适应各种语言任务,同时也意味着GPT-4接受了更多的数据训练,模型文件中有更多的权重(参数),这也使得它的运行成本更高。

此外,GPT-4可以更准确地解决人们的难题,多模态的GPT-4还可以生成、编辑具有创意性或技术性的文章,在高级推理方面的表现超过其前身。当然,正如大家所猜测的那样,微软New Bing的聊天功能确实基于GPT-4。OpenAI称,该模型“比以往任何时候都更具创造性和协作性”,“可以更准确地解决难题”。它可以解析文本和图像输入,尽管它只能通过文本进行响应。

官方表示,GPT-4错误答案更少,而且也会减少偏离话题的可能,也尽可能不会再谈论禁忌话题,甚至在许多标准化测试中比人类表现得都要更好一些。

例如,GPT-4在模拟律师考试的成绩在考生中排名前10%左右,在SAT阅读考试中排名前7%左右,在SAT数学考试中排名前11%左右。相比之下,GPT-3.5在律师考试中的得分一般都是倒数10%左右。当然,它们考个研究生还是没问题的。

不少业内人士也对GPT-4的未来应用前景表示看好,称GPT-4的出现将进一步推动AI语言模型领域的发展。作为下一代AI语言模型,GPT-4将会在各方面都得到进一步的改善,包括语言理解、生成、多语种支持等等。同时,GPT-4也将会在各个应用场景中得到广泛应用,为各个行业带来更加高效和智能的解决方案。

有网友4月份就对GPT-4是否退化发出质疑

那么,GTP-4真的如OpenAI自己所称的那样更强大吗?

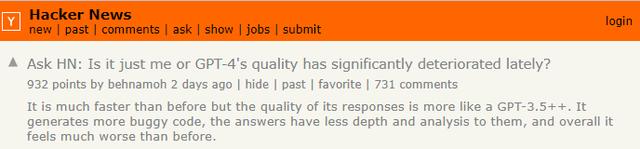

就在美东时间本周早些时候,Ycombinator上已有网友提出质疑,称“(GPT-4)确实比以前快很多,但它的输出质量更像是GPT-3.5++。GPT-4产生了更多的bug代码,答案也缺乏深度和分析,总体感觉上比以前要糟糕很多。”

在上述网友的帖子下方,另一名网友回复称,“是的。在更新之前,GPT(的上一个版本)能毫不费力地解决相当复杂的编程问题,并对非编程问题给出非常微妙且像是经过深思熟虑的答案。如今,GPT-4只能修改一个10行CSS模块中的两行,并再次给出这修改后的10行模块,不仅感到非常吃力,而且给出的答案中有些内容毫无关系……”

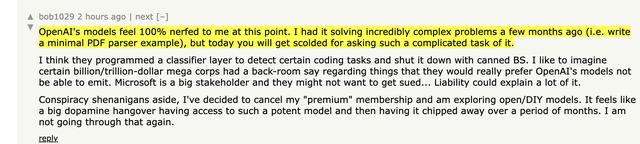

还有网友表示,“OpenAI的(最新)模型给我的感觉是100%被削弱了。几个月前我用它(的早期版本)解决了非常复杂的问题(例如编写一个最小的PDF解析器示例),但今天你会因为问了这么复杂的任务被GPT-4‘责备’。”这名网友最后还称,他已经决定取消订阅他的OpenAI会员资格。

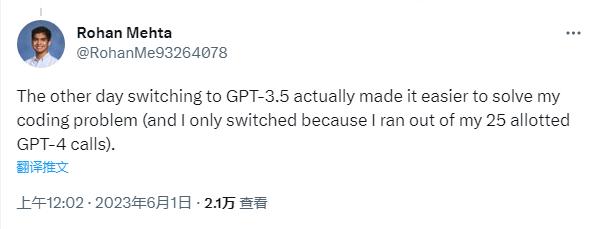

在推特上,有网友称把GPT-4的3小时25条对话额度一口气用完了,都没能解决自己的代码问题,最后无奈切换回了GPT-3.5。

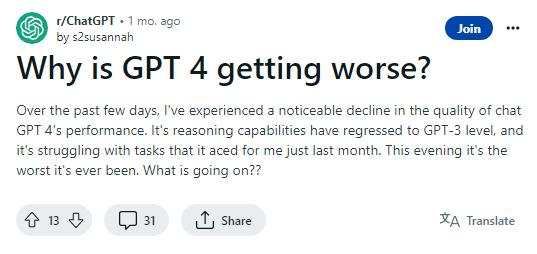

《每日经济新闻》记者还注意到,网上关于GPT-4是否退化的讨论,其实在1个月前就已经有了。当时有网友在美国版天涯+贴吧平台Reddit上,对GPT-4是否“变笨”发出质疑。这名当时网友称,“在过去几天里,我经历了GPT-4性能的明显下降。它的推理能力已经退化到GPT-3的水平,而且它正在努力完成上个月刚刚为我完成的任务。今晚的性能还是最糟糕的。这是怎么回事?”

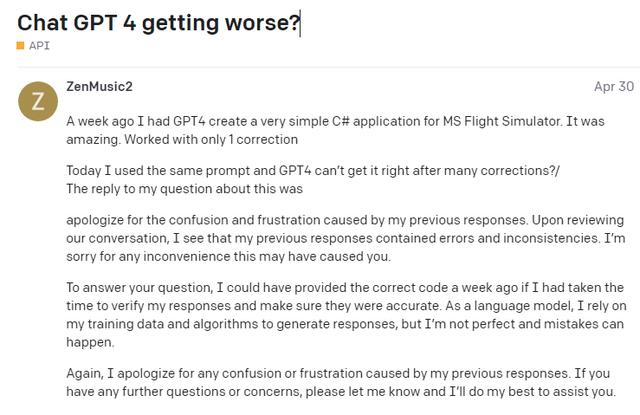

在OpenAI的官方开发者论坛,有网友在4月30日就发帖称,“一周前,我用GPT4为MS飞行模拟器创建了一个非常简单的C#应用程序。这太神奇了,我只(手动)更正了一次。今天我用了同样的提示词,但经过多次修改后GPT-4还是不能正常使用。”

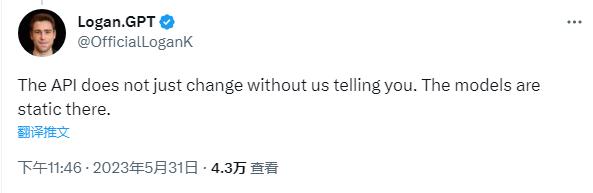

一时间,关于“GPT-4退化了”、“OpenAI为了节省成本开始偷工减料”等质疑声开始在Ycombinator、Reddit和推特等平台快速蔓延开来。速度如此之快,就连OpenAI官方的开发者推广大使Logan Kilpatrick都出面来公开回应网友的质疑:“API不会在没有我们通知您的情况下更改。”

在上述推文下方,Logan还回复了网友一些问题,他称,GPT-4自从3月14日发布以来未发生改动。他还表示,GPT-4对于一些提示词给出的回答内容不一致,是由于大模型本身不稳定。不过,针对网页版GPT-4是否被降级过的追问,均未得到其本人的正面回答。

另据监管机构NewsGuard的专家分析,OpenAI最新版本的GPT-4大型语言模型在输出信息方面,确实比它的前身GPT-3.5还要糟糕。在今年3月份发布的报告中,NewsGuard就指出,GPT-4不仅在其研究人员的提示下回答了完全虚假的新闻叙述,而且甚至比GPT-3.5回答的内容更差。