ChatGPT火了,英伟达笑了

英伟达又赚麻了。

1月3日——美股第一个交易日,英伟达的收盘价为143美元,一个月后的2月3日,英伟达股票的收盘价已经来到211美元,一个月涨了47%。华尔街分析师预计,英伟达在1月份的股价表现预计将为其创始人黄仁勋增加51亿美元的个人资产。

半导体企业股价的起起伏伏本属常态,可今时不同往日,半导体市场正在经历罕见的下行周期。英伟达股价此时的增长意味着,美股市场从它身上看到了逆境中的希望。

而这一希望之火的来源,就是当前科技圈的顶流:ChatGPT. 这款由OpenAI推出的聊天机器人在推出仅两个月后,月活跃用户就达到了1亿,成为历史上用户增长最快的消费应用。由于ChatGPT属于生成式AI,被誉为AI芯片第一股的英伟达应声而涨,在ChatGPT商业化模式尚未明确的初期阶段就斩获了一波红利。而美股市场如此看好英伟达,既有英伟达从显卡厂商成长为AI芯片霸主的历史原因,也在于ChatGPT当前阶段与英伟达生态的契合性。

缘何成为AI芯片第一股?

20世纪90年代,3D游戏的快速发展和个人电脑的逐步普及,彻底改变了游戏的操作逻辑和创作方式。1993年,黄仁勋等三位电气工程师看到了游戏市场对于3D图形处理能力的需求,成立了英伟达,面向游戏市场供应图形处理器。1999年,英伟达推出显卡GeForce 256,并第一次将图形处理器定义为GPU,自此GPU一词与英伟达赋予它的定义和标准在游戏界流行起来。

那时,三位创始人可能没有想到:

让英伟达股价飞升的不是游戏显卡,而是AI芯片。

让英伟达市值超越英特尔的不是游戏显卡,而是AI芯片。

在30年后,半导体遭遇罕见逆风的2022年,撑起英伟达财报表现的不是游戏显卡,而是包含AI加速、高性能计算、超算等业务的数据中心业务。至2023财年第三季度(截至2022年10月30日),数据中心业务的营收已经是游戏业务的两倍有余,对英伟达的营收贡献高达64.6%。

2021年第四季度(最右)—2023年第三季度(最左)英伟达各部门营收

来源:英伟达

来源:英伟达有意思的是,让英伟达踏上AI这条路的,不是GPU硬件,而是软件编程平台:CUDA(统一计算架构)。

在21世纪初,CPU难以继续维持每年50%的性能提升,而内部包含数千个核心的GPU能够利用内在的并行性继续提升性能,且GPU的众核结构更加适合高并发的深度学习任务。这一特性逐渐被深度学习领域的开发者注意。但是,作为一种图形处理芯片,GPU难以像CPU一样用C语言、Java等高级程序语言,极大地限制了GPU向通用计算领域发展。

英伟达很快注意到了这种需求。为了让开发者能够用英伟达GPU执行图形处理以外的计算任务,英伟达在2006年推出了CUDA平台,支持开发者用熟悉的高级程序语言开发深度学习模型,灵活调用英伟达GPU算力,并提供数据库、排错程序、API接口等一系列工具。虽然当时方兴未艾的深度学习并没有给英伟达带来显著的收益,但英伟达一直坚持投资CUDA产品线,推动GPU在AI等通用计算领域前行。

6年后,英伟达终于等到了向AI计算证明GPU的机会。在21世纪10年代,由大型视觉数据库ImageNet项目举办的大规模视觉识别挑战赛是深度学习的标志性赛事之一,被誉为计算机视觉领域的奥赛。在2010和2011年,ImageNet挑战赛的最低差错率分别是29.2%和25.2%,有的团队差错率高达99%,深度学习的前景因不确定性蒙上了一层阴影。

2012年,来自多伦多大学的博士生Alex Krizhevsky用120万张图片训练神经网络模型,和前人不同的是,他选择用英伟达GeForce GPU为训练提供算力。在当年的ImageNet,Krizhevsky的模型以约15%的差错率夺冠,震惊了神经网络学术圈。

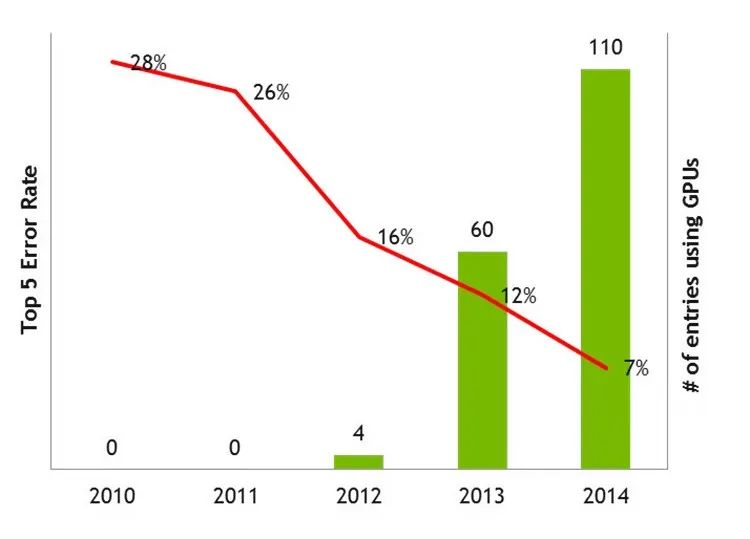

2010年—2014年,ImageNet top-5错误率(对一张图像预测5个类别)及GPU使用数量

(红色折线为错误率,绿色线柱为参赛团队GPU使用量)

这一标志性事件,证明了GPU对于深度学习的价值,也打破了深度学习的算力枷锁。自此,GPU被广泛应用于AI训练等大规模并发计算场景。数据显示,在2010-2011年,ImageNet挑战赛中没有任何团队使用GPU,2012年Krizhevsky首开先河后,2013年参赛团队使用的GPU达到了60块,2014年进一步提升至110块。

除了学术圈,科技企业也纷纷向英伟达伸出橄榄枝。2012年,英伟达与谷歌人工智能团队打造了当时最大的人工神经网络。到2016年,Facebook、谷歌、IBM、微软的深度学习架构都运行在英伟达的GPU平台上。2017年,英伟达GPU被惠普、戴尔等厂商引入服务器,被亚马逊、微软、谷歌等厂商用于云服务。2018年,英伟达为AI和高性能计算打造的Tesla GPU被用于加速美国、欧洲和日本最快的超级计算机。

与英伟达AI版图一起成长的,是股价和市值。2016年初,英伟达的股价在30美元左右。而2018年10月,英伟达股价来到292美元的高位,一度被资本市场誉为AI芯片第一股。2020年7月,英伟达市值首次超越英特尔,成为当时美国最大的芯片公司。

ChatGPT的最大受益者?

在AI计算领域的长期储备,让英伟达在ChatGPT尚处于商业化探索的早期,就率先受益,在股市斩获颇丰。接下来,ChatGPT的火热有望进一步体现在英伟达的销售额上。IDC亚太区研究总监郭俊丽向《中国电子报》表示,从算力来看,ChatGPT至少导入了1万颗英伟达高端GPU,总算力消耗达到了3640PF-days。

我们预计,ChatGPT很可能推动英伟达相关产品在12个月内销售额达到35亿至100亿美元。郭俊丽说。

ChatGPT引起了全球用户的极大兴趣,在于它能够满足各种各样的需求。解释名词概念、写作文、作诗、填写表单、编写SQL查询并且执行,甚至可以编写代码。而支撑这种多元化功能的,是AI大模型技术。一位AI从业者向《中国电子报》记者表示,大模型技术涉及AI开发、推理、训练的方方面面,所谓模型的大主要是参数量大、计算量大,需要更大体量的数据和更高的算力支撑。对于GPU厂商来说,大模型是值得期待的算力红利。

可英伟达真的能够在这一波算力红利中独占鳌头吗?如今,在通用GPU领域,AMD一直是独立GPU的第二大供应商,且一直保持着高速成长步伐,2022年AMD数据中心事业部的营业额实现了高达64%的同比增长。英特尔一直是全球最大的集成显卡供应商,在宣布重返独立GPU市场后,推出了面向数据中心和 AI 的Xe HP架构以及面向高性能计算的Xe HPC架构。与此同时,乘着AI东风崛起的一批中小GPU企业,也对新的市场机会虎视眈眈。显然,英伟达并不是AI开发者们的唯一选择。

那么,美股市场对英伟达的信心来源于什么?首先是GPU平台的通用性。一位互联网从业者向记者表示,小模型是做一个任务就训练一个模型,而大模型要具备一定的通用性。如果说对小模型的训练是一堂课,对大模型的培训就相当于九年义务教育。

而CUDA平台加持的英伟达GPU,就是以通用性见长。英伟达通用性高,支持AI的能力强。当一个新的AI热点出现,其成长过程中会出现哪些新型应用是难以在初期预测的,通用性强的芯片平台是更加安全的选择,因此AI开发者往往会优先选择英伟达的GPU。等这个AI热点成熟了,方向相对明确了,再去研发自己的芯片。Gartner研发副总裁盛陵海向记者表示。

英伟达的另一道护城河,是其AI生态的黏性。CUDA几乎只支持英伟达的Tesla架构GPU,不容易迁移,有利于AI开发者与英伟达软硬件长期绑定。在AI领域,英伟达的GPU占据绝对的领导地位,在训练领域英伟达的GPU产品的市场份额超过80%。再配合CUDA软件工具,实现对GPU等硬件芯片的捆绑,构筑了行业壁垒。赛迪顾问集成电路产业研究中心总经理滕冉向记者表示。

这波红利能吃多久?

在英伟达的发展史中,令其股价飙升的热点有很多。有些是技术畅想,比如AI和元宇宙,在为全社会带来想象空间的同时,也倒逼英伟达推出了新的产品和平台。但也有一些是单纯的GPU走量,比如挖矿,虽然短期内急速拉升了英伟达和AMD的显卡销量,但也对芯片供应秩序和GPU厂商财务表现的稳定性造成了伤害,成了昙花一现的短期红利。

ChatGPU带来的算力红利,又能持续多久?这个问题,可以分两个层次来看。

第一个层次,在于ChatGPU是不是一项能够长期发展的颠覆性技术。

在黄仁勋本人看来,答案是肯定的。在近期参加的Berkeley Haas 商学院 Dean’s Speaker 系列谈话中,黄仁勋表示人工智能领域出现了ChatGPT,相当于手机领域出现了iPhone:ChatGPT 的出现对人工智能领域的意义,类似手机领域‘iPhone’的出现。这一刻在科技领域具有里程碑的意义,因为现在大家可以将所有关于移动计算的想法,汇集到了一个产品中。例如,通过API接口,可以将ChatGPT连接到数据表、Powerpoint、绘图程序,照片编辑程序等,一切都可以变得更完善。

但也有观点认为,ChatGPT并没有为底层技术带来变革。Meta首席AI科学家、图灵奖得主杨立昆表示,ChatGPT并没有为底层技术带来创新,更多的是一个组合得很好的产品。盛陵海向记者表示,目前来看ChatGPT还是基于现有的数据进行组合式回答,而不是去创造新的内容。ChatGPT要长远发展,需要持续向生产工具演变,比如短期内可以用来提升搜索引擎的正确率,而不是仅仅停留在与用户对话。

在芯片层面,尚未看到针对ChatGPT推出的新产品。但ChatGPT作为明星产品,引发的是全社会对于生成式AI和大模型技术的关注,而后者对于芯片用量的更大需求、芯片规格的更高要求,已经是较为明朗的趋势。未来大模型将成为AI技术领域重要的生产工具,需要更强的训练、推理能力,支撑海量数据模型且高效地完成计算,这些要求会对芯片的算力、存储容量、软件栈、带宽等技术有更高的要求。郭俊丽表示。

其次是在ChatGPT等生成式AI发展的不同时期,英伟达的蛋糕份额是否会有所变化。

对于中小企业来说,一旦想明白了要用ChatGPT做什么,按照业务特点定制AI芯片,是更经济的选择。郭俊丽表示,随着ChatGPT技术不断成熟推进、算法不断优化普及,ASIC将更具备竞争优势。

而头部企业普遍想从芯片层、框架层、模型层一直做到应用层,因而无论国际的谷歌、微软、亚马逊,国内的百度、阿里,都推出了自己的算力芯片。为了让芯片层更加贴合自己的框架模型,科技企业会不断提升软硬件的契合度,进一步提升自研芯片的比例。

因此,当ChatGPT发展到成熟期,其算力底座有可能从英伟达独占鳌头的局面逐渐向百家争鸣的割据战倾斜,从而压缩英伟达在该领域的盈利空间。但那个时期,可能又会有下一个AI热点出现,开启下一轮从通用GPU平台进行早期探索的循环。毕竟芯片企业的起起落落,概念股票的跌跌涨涨,都源于人们对于技术进步和美好生活的期待。只要想象力不会终止,就永远有新的发现令市场瞩目,新的热点供企业追逐。

延伸阅读:

大数据文摘出品

作者:Andy

要说整个19年自然语言处理界,不,应该说深度学习界的流量巨星,都不得不提OpenAI的GPT2模型。

一放出就在7个Zero-Shot任务上取得SOTA,其强大的文本生成能力让人震惊,直接弥补了BERT文本生成的缺陷,甚至连它的创造者们 OpenAI 也发言表示Too Dangerous To Release(太危险了不能公开),结果在社交媒体上引起了一片争论:有挺OpenAI派表示应该对这种模型进行限制,也有反OpenAI派表示就是炒作,放出来估计也没啥事。

当然,这一系列的争论最终的受益者无疑是OpenAI ,可算是一整年出尽了风头,从二月到去年十一月都有GPT2的持续报道。

消停了半年,上周,OpenAI 又放了个大招:GPT3突然放出。文摘菌的朋友圈瞬间被刷爆,reddit上也进行了激烈讨论。

GPT3之所以能引起这么大关注,首先当然是爸爸GPT2的功劳。

炒作了整个19年,就那几个模型还悄咪咪地一点点放出来,从年初一直放到年末。当然GPT2本身在生成式的效果也是毋庸置疑的,所以大家也拿着GPT2搞出了各种脑洞大开的应用,比如用它下棋,还有人把它做成一款文字冒险游戏等等。

大招or刷榜?OpenAI耗资8500万炼出的GPT3,它真的不香吗