AI绘画:下载和使用各种模型

寻找下载模型,尝试各种模型的效果是使用AI绘画的乐趣之一。

安装完Stable Diffusion,才是真正折腾AI绘画的开始。那就是寻找和下载、尝试各种模型。本文就来说说折腾Stable Diffusion你一定会用到的几种常用模型。

上一篇文章说了如何成功安装部署StableDiffusion。这篇文章来看看那些让人着迷的各种模型。

二、模型

不同模型的说明。如果你去自己下载模型,就会发现有各种不同类型的模型。

具体模型类型有checkpoint、Textual lnversion、Hypernetwork、Aesthetic Gradient、LoRA、LyCORIS、Controlnet、Poses、wildcards等等,看得人眼花缭乱。这些都是什么意思呢?

本文就先从几种主要的模型说起。

1、Checkpoint/大模型/底模型/主模型

Checkpoint模型是SD能够绘图的基础模型,因此被称为大模型、底模型或者主模型,WebUI上就叫它Stable Diffusion模型。安装完SD软件后,必须搭配主模型才能使用。不同的主模型,其画风和擅长的领域会有侧重。

checkpoint模型包含生成图像所需的一切,不需要额外的文件。但是它们体积很大,通常为2G-7G。

常见文件模式:尾缀ckpt、safetensors(如果都有提供的话建议下载safetensors,下同)

存放路径: \models\Stable-diffusion

目前比较流行和常见的checkpoint模型有Anything系列(v3、v4.5、v5.0)、AbyssOrangeMix3、ChilloutMix、Deliberate、国风系列等等。

此外,stable diffusion官方的模型当下较受欢迎的有以下几个:(这些模型授权均可商业化使用。)

1)、runwayml主模型(checkpoint)

下载路径:https://huggingface.co/runwayml/stable-diffusion-v1-5

特点:Stable Diffusion是一个潜在的文本到图像的扩散模型(a latent text-to-image diffusion model),能够在任何文本输入的情况下生成照片般真实的图像。关于稳定扩散功能的更多信息,请看链接(https://huggingface.co/blog/stable_diffusion)。Stable-Diffusion-v1-5 checkpoint 以Stable-Diffusion-v1-2checkpoint的权重初始化,随后在 "laion-aesthetics v2 5+"上以512x512的分辨率对595k步进行微调,并放弃10%的文本条件以改善无分类器指导采样。

模型语言:英文

模型选择:

v1-5-pruned-emaonly.ckpt(https://huggingface.co/runwayml/stable-diffusion-v1-5/resolve/main/v1-5-pruned-emaonly.ckpt) - 4.27GB, ema-only(指数移动平均汉) weight. uses less VRAM(对内存要求较低) - suitable for inference(适用于推理生成)

v1-5-pruned.ckpt(https://huggingface.co/runwayml/stable-diffusion-v1-5/resolve/main/v1-5-pruned.ckpt) - 7.7GB, ema+non-ema weights. uses more VRAM(对内存要求较高) - suitable for fine-tuning(适合于微调)

模型类型:Diffusion-based text-to-image generation model(基于扩散算法的文生图的生成模型)

模型授权:The CreativeML OpenRAIL M license (可商业化使用)

2)CompVis主模型(stable-diffusion-v1-4)

特点:Stable Diffusion是一个潜在的文本到图像的扩散模型,能够在任何文本输入的情况下生成照片般真实的图像。关于稳定扩散功能的更多信息。

Stable-Diffusion-v1-4 checkpoint 以Stable-Diffusion-v1-2 checkpoint的权重初始化,随后在 "laion-aesthetics v2 5+"上以512x512的分辨率对225k步进行微调,并放弃10%的文本条件以改善无分类器指导采样。

模型语言:英文

2、LoRA/微调模型

也是当下最火的微调模型,可以将某一类型的人物或者事物的风格固定下来。它们通常为10-200 MB。必须与checkpoint模型一起使用。

常见文件模式:尾缀ckpt、safetensors、pt

存放路径: \models\Lora

有多个使用方式:

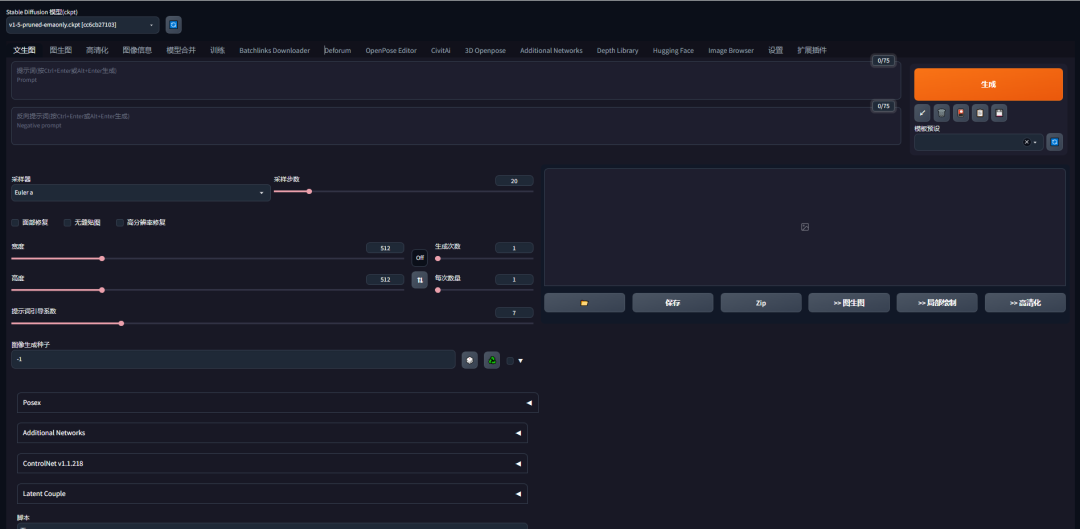

方法1:在生成界面调取选用。Stable-Diffusion-WebUI的使用方式。

方法2:以插件形式使用

3、VAE/美化模型/变分自编码器

VAE,全名Variational autoenconder,中文叫变分自编码器。作用是:滤镜+微调。有的大模型是会自带VAE的,比如Chilloutmix。如果再加VAE则可能画面效果不会更好,甚至适得其反。

通常系统自带的VAE是anime(单指日本动画) vae,效果一般,建议可以使用kl-f8-anime2或者vae-ft-mse-840000-ema-pruned。anime2适合画二次元,840000适合画写实人物。

常见文件模式: 尾缀ckpt、pt

存放路径: \ models\VAE

1)color101-v1.vae

在civitai网站上下载量超9.3K。

介绍:与840000、Anything、kl-f8-anime2等常见的VAE相比,一种用于生成更高动态和更自然的图像的VAE。

重要提示:根据反馈,这个VAE可能在小的分辨率上产生不理想的结果,如512x512。Color101更适合于直接生成大的图像(这是我在调整这个VAE时做的),或者使用hires fix来生成更大的分辨率。

2)vae-ft-mse-840000-ema-pruned.safetensors